Contexte

Sandaya, leader dans l’hôtellerie de plein air, a entamé la refonte de sonProperty Management System (PMS), un élément central pour la gestion des réservations, des inventaires et des clients. Cette modernisation a révélé le besoin de transformer les flux de données reliant le PMS aux autres systèmes stratégiques (comptabilité, CRM, BI, gestion des avis clients, etc.).

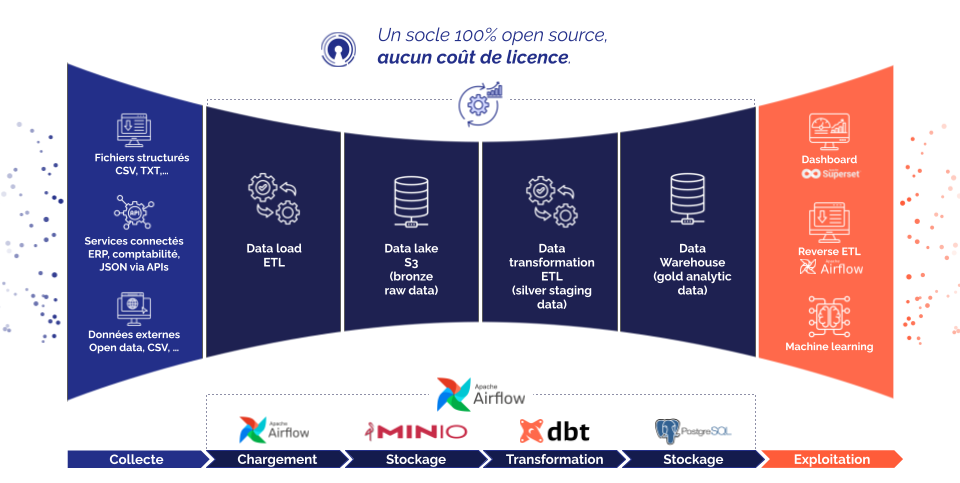

Jusqu’alors, ces flux étaient fragmentés et reposaient souvent sur des processus manuels (fichiers CSV), entraînant un manque de traçabilité, une maintenance complexe et une dispersion des données. Sandaya a ainsi opté pour un pipeline de données automatisé et centralisé, capable d’assurer fiabilité, efficacité et évolutivité, tout en soutenant la transformation de son infrastructure numérique.

Objectifs

- Assurer une refonte complète et conforme des flux de données ISO, pour garantir la migration réussie et intégrale du PMS vers le nouveau système.

- Centralisation des données : Réunir la gestion des flux de données dans un pipeline unique pour éliminer les approches disparates actuelles.

- Visibilité et monitoring : Offrir des interfaces de suivis claires permettant de suivre en temps réel l’exécution et l’état des flux.

- Traçabilité : Garantir un suivi précis des données à travers leur cycle de vie, pour une meilleure gouvernance et une conformité accrue.

- Maintenance simplifiée : Créer une architecture robuste et bien documentée, facilitant la gestion et les évolutions futures.

- Réduction des erreurs de transfert de données à un niveau proche de zéro grâce à l'automatisation.

Résultats

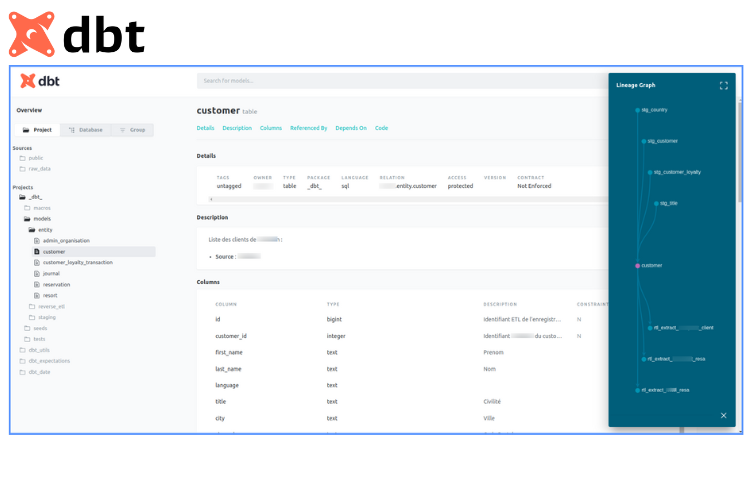

- Mise en place d’un pipeline de données moderne : Basé sur Apache Airflow pour l’orchestration des tâches et dbt pour la transformation des données, garantissant une gestion automatisée et performante des flux.

- Architecture en médaillon : Implémentation d’une architecture data conforme aux bonnes pratiques, structurée autour des couches brutes (raw), intermédiaires (staging) et finales (gold).

- Approche “Data as Code” : Adoption d’une méthodologie inspirée des pratiques de développement logiciel classique.

- Amélioration de la gouvernance des données : Avec des outils et processus intégrés pour la documentation, la supervision et le respect des normes en vigueur.

.png)

.png)

.png)

.jpg)